人工智能决策 让系统决定是否引爆火箭,靠谱吗?

在航天探索领域,每一次发射都伴随着巨大的风险和不确定性。随着人工智能技术的迅猛发展,一种新的可能性开始浮现:能否让智能系统在关键时刻自主决定是否引爆火箭?这一设想引发了广泛讨论,其背后涉及技术可行性、伦理考量与风险控制等多重维度。

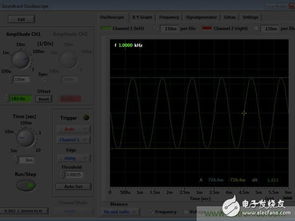

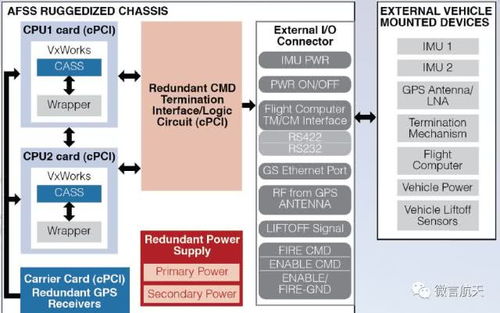

从技术层面看,人工智能系统在处理海量数据、快速分析复杂情境方面具有独特优势。火箭发射过程中,传感器会实时收集数以万计的数据点,包括温度、压力、振动频率等。人类工程师需要时间消化这些信息并做出判断,而AI系统可以在毫秒级别内完成模式识别与异常检测。例如,SpaceX的猎鹰火箭已部分采用自动安全系统,能够在发动机失效等紧急情况下触发自毁程序,以防止更大灾难。这表明,在某些预设规则清晰的场景中,自动化决策已具备一定可靠性。

将‘是否引爆’这样的终极决策完全交由AI,仍面临重大挑战。最核心的问题在于‘不可预见的复杂性’。火箭发射是一个高度动态的过程,可能遭遇传感器故障、软件漏洞或未曾预料的物理交互。AI系统依赖历史数据训练,但航天任务中常遇到‘未知的未知’——即训练数据中从未出现过的故障模式。2019年印度月船2号着陆器失事,部分原因正是制导算法未能处理实际着陆时出现的异常情况。若将引爆权交给AI,系统能否在极端意外中做出符合人类价值判断的选择?

伦理与责任归属是另一关键难题。如果AI错误引爆火箭导致任务失败,责任应由谁承担?开发者、运营商还是算法本身?目前法律框架尚未能妥善界定自主系统的责任边界。欧洲航天局已在《太空伦理准则》中强调,任何自动化决策必须保留‘人类监督环’,确保最终控制权掌握在人类手中。这并非不信任技术,而是认识到生命与重大资产决策需要可追溯的问责机制。

从风险控制角度,分层级决策系统或许是更可行的路径。例如,将决策分为三个层级:第一层由AI处理明确规则下的常规故障(如发动机压力超标);第二层引入人机协同,当AI检测到模糊威胁时向人类操作员提供多套应对方案;第三层保留人类独家决策权,用于处理涉及伦理或战略价值的极端情况。美国NASA在火星探测器任务中已采用类似架构,既发挥AI实时响应优势,又确保人类对关键节点的把控。

公众接受度也不容忽视。航天任务往往承载着国家荣誉与科学梦想,民众对‘机器决定火箭存亡’的信任度需要长期培育。透明化AI决策逻辑、开展模拟演练公开演示、建立第三方验证机制,都是提升社会信心的必要举措。

随着强化学习、数字孪生等技术的发展,AI决策系统有望在虚拟环境中经历数百万次‘压力测试’,积累应对罕见故障的经验。但技术成熟不等于可以消除人类角色。正如自动驾驶领域倡导的‘有意义的人类控制’原则,航天决策或许最终会走向‘增强智能’模式——AI成为人类判断的超级增强工具,而非替代者。

让系统决定是否引爆火箭,既不是天方夜谭,也不是一蹴而就的简单命题。它需要工程师在算法可靠性上精益求精,伦理学家在法律框架上未雨绸缪,社会在技术接受度上逐步构建共识。只有当技术护栏、伦理准则与人类智慧形成三重保障时,我们才能真正自信地说:这个决定,既智能又可靠。

如若转载,请注明出处:http://www.keywordsoo.com/product/63.html

更新时间:2026-02-25 04:39:54